Dalam beberapa waktu belakangan ini dikejutkan dengan dunia AI (kecerdasan buatan) yang dimana bisa membantu dalam pekerjaan digital untuk menyelesaikan pekerjaannya dalam waktu singkat dan efisien. Ada beberapa penggunaan AI seperti ChatGPT yang merupakan tools LLM yang belakangan ini dipakai oleh pengguna untuk mencari jawaban dari persoalan yang ada tanpa perlu menjelajah jawaban ke internet seperti Google Search, Bing, dll.

Namun, LLM Tools dalam belakangan ini telah membuat langganan dengan sistem berbayar yang dimana hasil langganan tersebut dapat meningkatkan performa LLM Tools online itu sendiri. Hal ini membuat penulis mencari cara dalam menggunakan LLM Tools seperti ChatGPT secara gratis dan tidak harus koneksi internet (kecuali ada pembaharuan Models dari Ollama itu sendiri). Akan tetapi, untuk memasang LLM Tools versi offline di standalone (PC atau laptop) pasti membutuhkan spesifikasi yang tinggi pula agar bisa berjalan dengan maksimal.

Daftar Isi

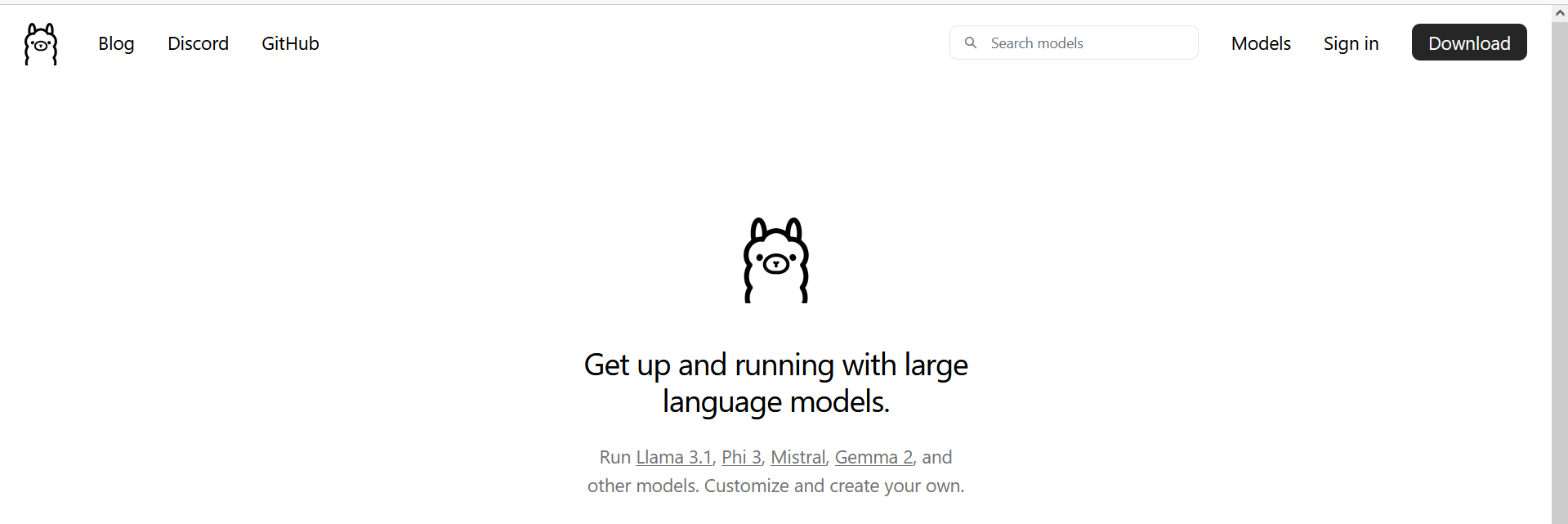

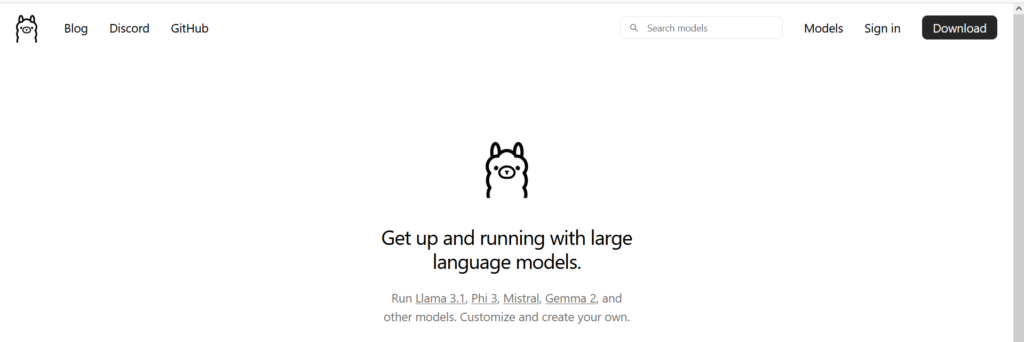

PENGENALAN OLLAMA

LLM Tools versi Offline kali ini adalah Ollama. Ollama bisa dijalankan melalui CLI atau CMD (khusus Windows) atau menggunakan WebUI khusus menjalankan Ollama pakai GUI. Tools ini gratis dan enak digunakan bagi siapapun bahkan bisa integrasikan ke teks Editor seperti Visual Studio Code.

Dengan adanya LLM Tools offline tersebut, maka kamu bisa melakukan dalam instalasi ChatGPT versi standalone. Namun, tidak menutup kemungkinan Ollama ini bisa dijadikan server online yang dimana ChatGPT secara custom ini bisa diakses beberapa pengguna.

Jadi, kamu bisa mencari referensi atau jawaban dari persoalan yang ada tanpa harus menggunakan LLM Tools online seperti ChatGPT, Google Gemini dkk.

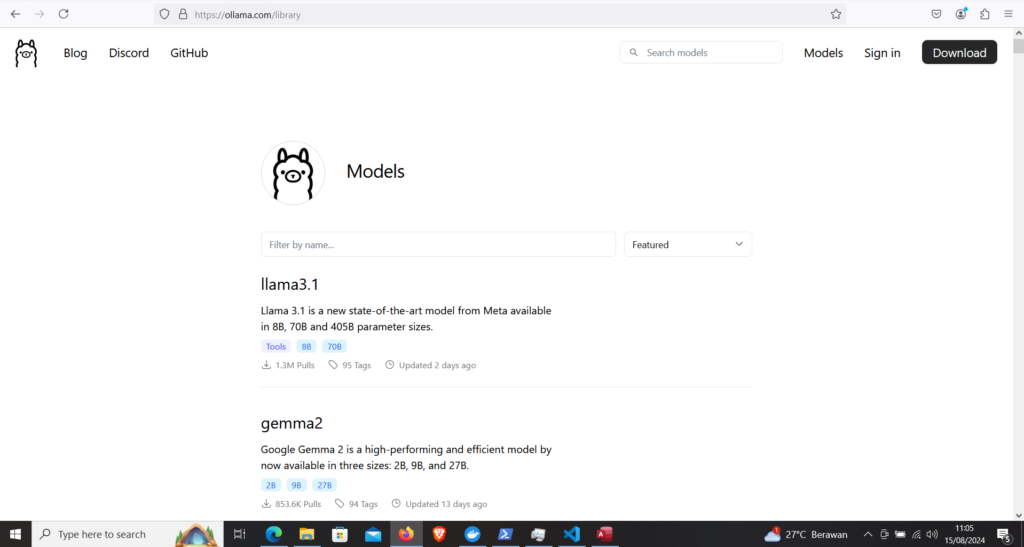

LIST MODEL DI OLLAMA

Di dalam situs tersebut ada terdapat beberapa models yang tersedia di pada laman Llama yang bisa dipasangkan atau ditambahkan ke dalam laptop atau PC dengan sesuai kebutuhan dan spesifikasi PC atau laptop yang digunakan. Jika kamu tambahkan container models ke dalam PC atau laptop yang kurang memenuhi syarat dalam total parameter sekitar miliaran, maka laptop atau PC akan terjadi not responding atau lemot bahkan bisa bikin panas.

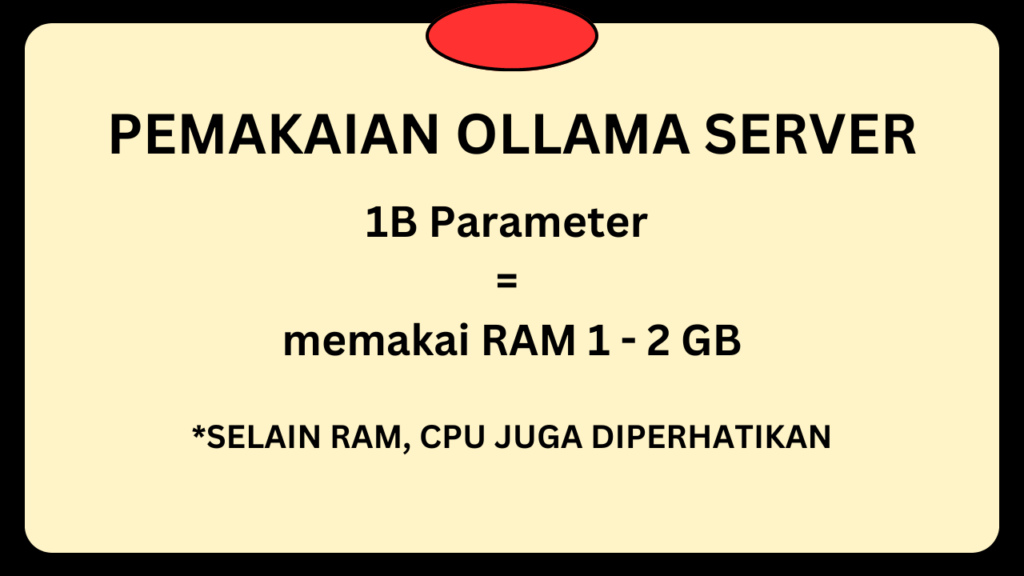

Ada beberapa hal yang harus diperhatikan sebelum menambahkan container models ke dalam Ollama di PC atau laptop, maka harus memperhatikan penampungan data parameter dalam satuan B (Bilion) yang sangat pengaruh dalam pemakaian RAM pada saat proses untuk mencari jawaban dari LLM Tools yang telah terpasang container models.

Selain pemakaian RAM yang diperhatikan, pemakaian CPU juga diperhatikan, semakin tinggi spesifikasi CPU tanpa terbatas seperti processor yang series model U atau Y, semakin cepat dalam bekerja LLM Tools untuk mendapatkan jawaban dari soal yang diberikan kepada Ollama. Jika ada GPU beneran seperti NVIDIA dkk, maka lebih mudah dilakukan proses AI yang terutama melibatkan grafik atau gambar.

PENGGUNAAN OLLAMA DI LAPTOP ATAU PC

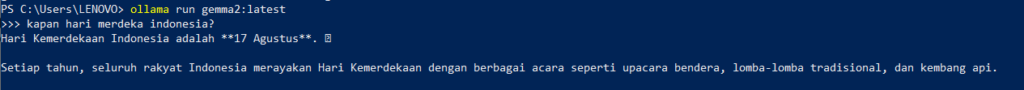

Disini bisa melihat dari penggunaan Ollama di laptop atau PC yang terdapat pada gambar dibawah ini tentang proses kerja AI dalam menemukan jawaban dari prompt yang diberikan.

Nah, kamu telah mendapatkan informasi dari soal atau prompt yang diberikan kepada Ollama untuk diproses dalam mencari jawaban bantuan AI Models.

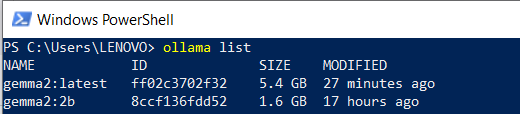

Pada bagian ini juga bisa melihat ada beberapa container models yang terpasang di dalam Ollama pada PC atau laptop yang bisa dilihat pada dibawah ini.

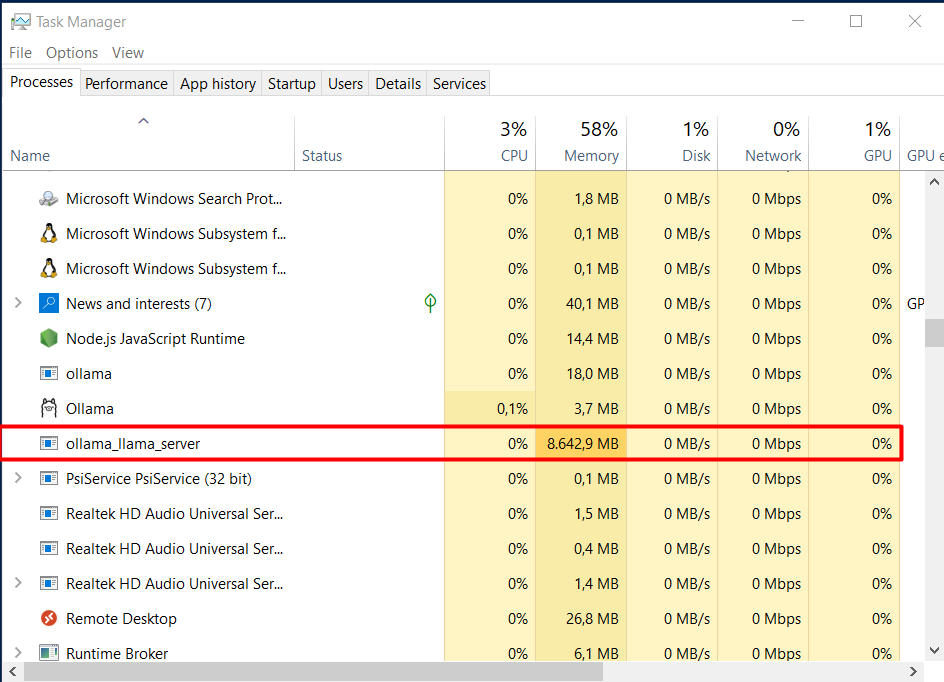

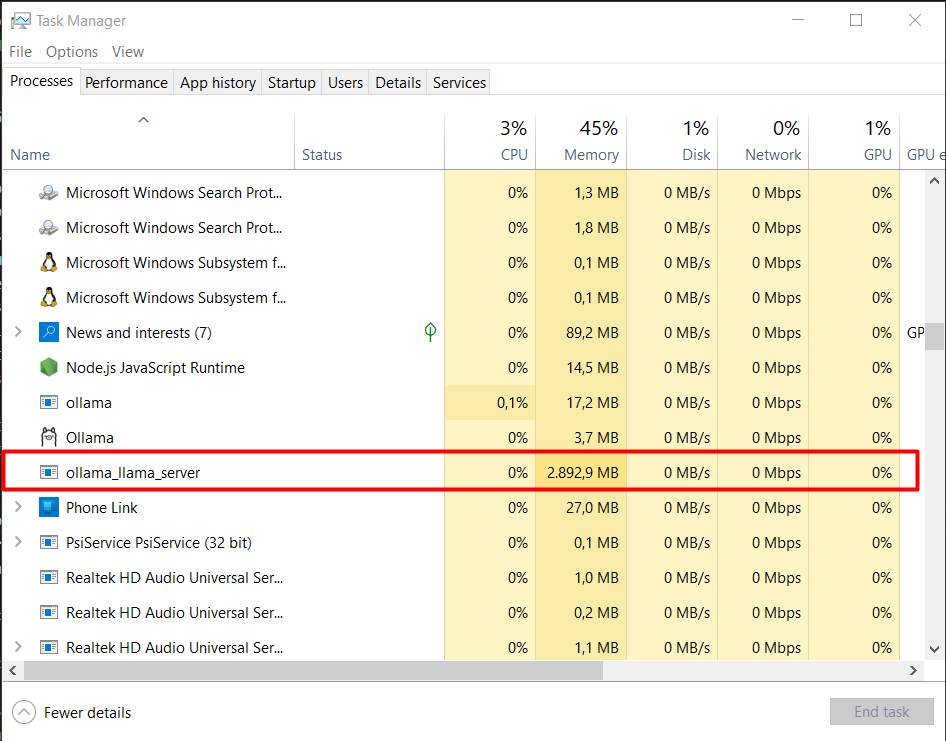

Disini juga bisa melihat pemakaian RAM dalam menggunakan Ollama Server sebagai LLM tools versi perangkat lokal (standalone) yang terdapat pada gambar dibawah ini.

MENGGUNAKAN CONTAINER MODELS gemma2:latest

Disitu ada pemakaian RAM sekitar 8.642 MB khusus ollama_llama_server (Ollama) yang diaktifkan container yang memiliki data model sebanyak 8B Parameters yang nama models adalah gemma yang versi latest(gemma2:latest).

MENGGUNAKAN CONTAINER MODELS gemma2:2b

Disitu ada pemakaian RAM sekitar 2.892 MB khusus ollama_llama_server (Ollama) yang diaktifkan container yang memiliki data model sebanyak 2B Parameters yang nama models adalah gemma yang versi lite (gemma2:2b). 2b disini maksudnya data model ada 2 Bilion Parameters.

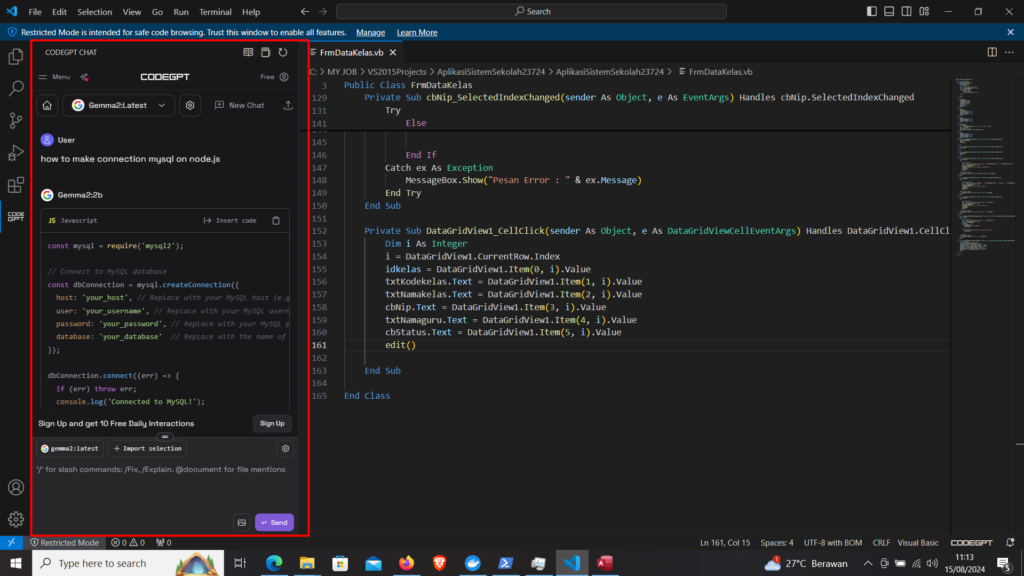

INTEGRASI OLLAMA DENGAN VISUAL STUDIO CODE

Kamu bisa melakukan integrasi Ollama tadi ke dalam salah satu teks editor yang banyak digunakan oleh programmer atau IT engineer yaitu Visual Studio Code dengan memasang extension CodeGPT. Setelah proses instalasi, kamu bisa memilih salah satu container models yang ada di Ollama pada laptop atau PC untuk melakukan integrasi LLM tools dengan Visual Studio Code sehingga apabila kamu ada kesulitan dalam melakukan ngoding atau mengetik di Visual Studio Code, maka bisa menggunakan extension CodeGPT untuk mencari atau mendapatkan informasi yang kamu butuhkan.

PENUTUP

Kamu bisa memasang ChatGPT versi laptop atau PC lokal (standalone) dengan menggunakan LLM Tools yaitu Ollama yang dimana banyak terdapat container Models yang bisa ditambahkan ke dalam Ollama dengan sesuai kebutuhan atau spesifikasi laptop atau PC yang kamu gunakan saat ini.

Setelah itu, kamu bisa mencari informasi dari persoalan dengan memberikan prompt untuk mencari jawaban melalui AI Models dari Ollama yang dimana container models sedang aktif di laptop atau PC. Hal ini bisa memudahkan dalam pekerjaan digital sehari-hari.

INGAT! Jangan digunakan sebagai jawaban utama pada saat mengikuti ujian masuk atau seleksi masuk ke kampus favorit, seleksi esai untuk mendapatkan beasiswa, dsb. tetap gunakan jawaban berdasarkan pengetahuan atau pengalaman yang kamu ketahui.